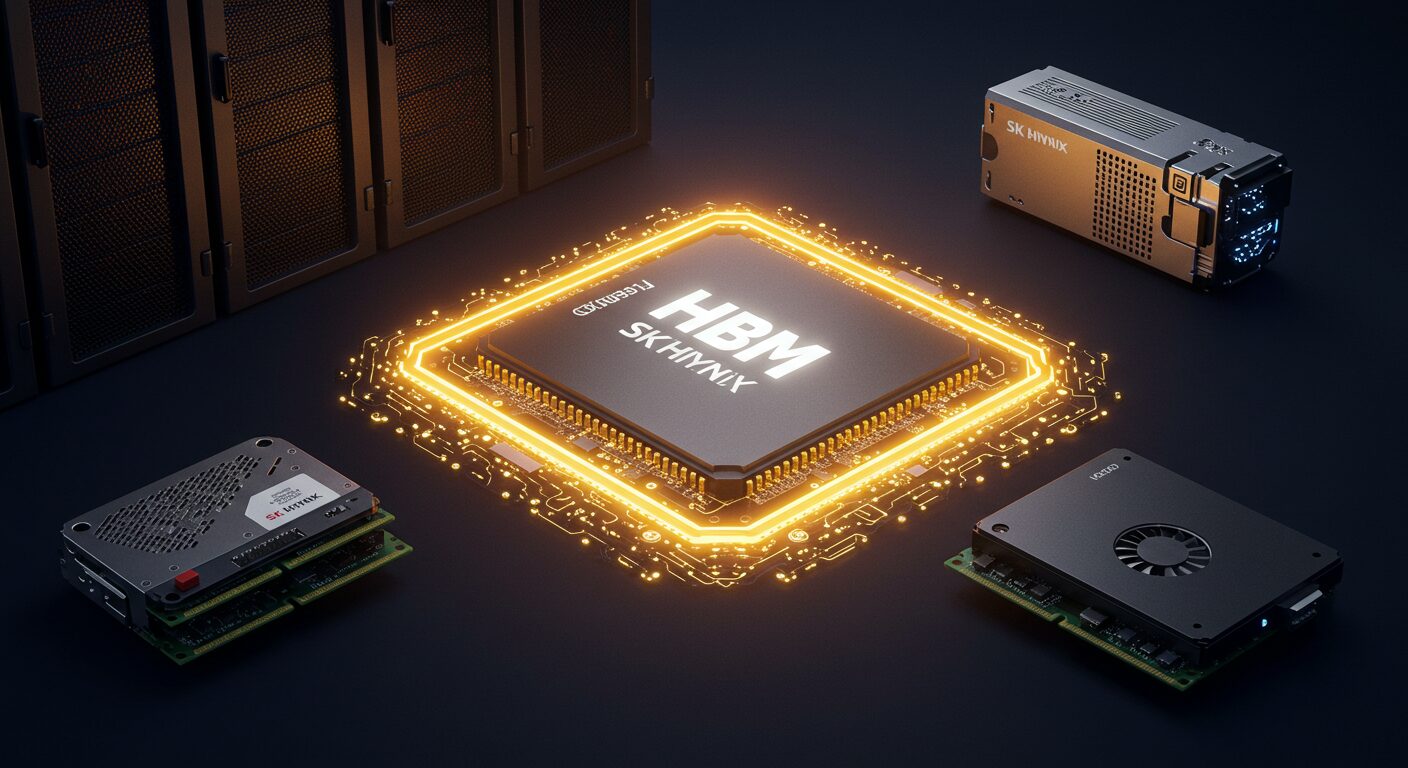

안녕하세요, 여러분! 😊 요즘 ChatGPT나 AI 이미지 생성 같은 인공지능 서비스 많이 사용하고 계시죠? 그런데 이런 놀라운 AI 기술 뒤에 숨어있는 핵심 부품이 있다는 사실, 알고 계셨나요? 바로 HBM 메모리입니다!

오늘은 AI 반도체 시장에서 가장 뜨거운 이슈인 HBM에 대해 쉽고 재미있게 알아보려고 해요. 💡 SK하이닉스가 어떻게 글로벌 1위가 되었는지, 그리고 왜 엔비디아 같은 빅테크 기업들이 HBM을 놓고 난리인지 함께 살펴볼게요!

🔍 HBM 메모리란 무엇인가요?

HBM은 High Bandwidth Memory의 약자로, 초고속 데이터 전송이 가능한 차세대 메모리를 의미해요. 일반 D램과 달리 여러 개의 메모리 칩을 수직으로 쌓아 올린 3D 구조가 특징이죠.

쉽게 비유하자면, 일반 D램이 넓은 땅에 지은 단독주택이라면 HBM은 최첨단 초고층 아파트와 같아요. 같은 면적에 훨씬 더 많은 세대를 수용할 수 있고, 엘리베이터로 빠르게 이동할 수 있는 것처럼, HBM도 좁은 공간에서 엄청난 양의 데이터를 빠르게 처리할 수 있답니다. 🏢

💫 HBM이 AI에 필수적인 이유

인공지능, 특히 ChatGPT 같은 대규모 언어 모델은 수천억 개의 파라미터를 기반으로 작동해요. 이 파라미터들은 AI의 두뇌인 GPU가 끊임없이 접근해야 하는 데이터입니다.

문제는 GPU의 연산 속도는 빠르게 발전했지만, 데이터를 전달하는 통로의 속도가 따라가지 못했다는 점이에요. 이를 메모리 월(Memory Wall) 현상이라고 부르는데, HBM 메모리가 바로 이 문제의 해결사랍니다! ⚡

🎯 HBM의 핵심 기술, TSV란?

HBM의 비밀은 TSV(Through-Silicon Via) 기술에 있어요. 이는 실리콘을 관통하는 전극으로, 수직으로 쌓인 메모리 칩들을 연결하는 초미세 전용 통로예요.

TSV 덕분에 데이터 이동 거리가 극단적으로 짧아지고, 한 번에 처리할 수 있는 데이터 양도 기존 대비 수십 배 증가했어요. 출입구(I/O)를 무려 1,024개까지 늘릴 수 있어서, 마치 수백 개의 창문을 통해 동시에 물건을 나르는 것과 같은 효과를 낸답니다! 📦

🏆 SK하이닉스는 어떻게 HBM 시장 1위가 되었을까?

SK하이닉스의 성공 비결은 단순히 시장에 먼저 진입했기 때문이 아니에요. 경쟁사들이 쉽게 따라올 수 없는 강력한 기술적 해자를 구축했기 때문이죠.

🔬 독보적인 MR-MUF 공법

SK하이닉스의 핵심 기술은 MR-MUF(Mass Reflow Molded Underfill) 공법이에요. 이는 여러 개의 칩을 쌓은 후, 칩 사이의 미세한 틈을 액체 형태의 보호재로 한 번에 채워 굳히는 방식입니다.

이 방식의 가장 큰 장점은 열 방출에 매우 유리하다는 점이에요. HBM처럼 좁은 공간에 열원이 밀집된 구조에서는 열 관리가 제품의 신뢰성을 좌우하거든요. 또한 공정이 단순해서 생산성과 수율을 높이는 데도 효과적이랍니다! 🌡️

⚙️ 경쟁사와의 기술 격차

반면 삼성전자가 초기에 사용했던 TC-NCF(Thermal Compression Non-Conductive Film) 방식은 칩을 한 층씩 쌓을 때마다 필름을 삽입하고 압착해야 해서 공정이 복잡했어요.

층이 높아질수록 미세한 기포나 이물질 유입 확률이 높아져 수율 확보에 어려움을 겪었고, 필름 소재의 특성상 열전도율도 MUF 방식보다 낮았답니다. 이런 기술적 차이가 시장 점유율의 명확한 격차로 이어졌어요. 📊

💼 엔비디아와의 전략적 파트너십

SK하이닉스와 엔비디아의 관계는 단순한 공급사-고객사 관계를 넘어서요. 이들은 기술의 미래를 함께 설계하는 전략적 동맹 관계랍니다! 🤝

🚀 공동 개발의 선순환 구조

엔비디아는 차세대 GPU를 설계하는 단계부터 SK하이닉스와 긴밀하게 협력해요. 미래의 AI 칩이 요구하는 메모리 사양을 공유하고, SK하이닉스는 그에 맞춰 HBM을 개발하는 거죠.

이런 협력은 세 가지 강력한 이점을 만들어냅니다. 첫째, 경쟁사보다 먼저 차세대 기술의 방향성을 파악할 수 있어요. 둘째, HBM이 엔비디아 GPU에 최적화되어 최고의 성능을 발휘합니다. 셋째, 경쟁사들에게는 넘기 어려운 높은 진입 장벽이 되죠. 🎯

실제로 SK하이닉스는 엔비디아의 H100 GPU에 HBM3를 독점 공급하며 시장 주도권을 장악했고, 차세대 HBM3E에서도 가장 먼저 품질 인증을 통과했답니다!

🌟 후광 효과로 전체 사업 확대

HBM에서의 리더십은 SK하이닉스의 다른 제품에도 긍정적인 영향을 미쳐요. 구글, 마이크로소프트, 아마존 같은 하이퍼스케일러들이 AI 데이터센터를 구축할 때, SK하이닉스를 신뢰할 수 있는 기술 파트너로 인식하게 되거든요.

덕분에 일반 서버 D램이나 기업용 SSD 시장에서도 더 나은 가격을 받고 시장 점유율을 확대할 수 있어요. HBM 사업을 넘어 회사 전체의 수익성을 끌어올리는 중요한 동력이 되는 거죠! 💰

📈 HBM 시장의 미래 전망

AI 기술이 계속 발전하면서 HBM 메모리에 대한 수요는 폭발적으로 증가하고 있어요. 시장조사기관들은 HBM 시장이 연평균 30% 이상 성장할 것으로 전망하고 있답니다.

특히 ChatGPT 같은 생성형 AI가 대중화되면서, 더 많은 기업들이 AI 인프라에 투자하고 있어요. 이는 곧 HBM 수요의 지속적인 증가로 이어질 거예요. 📱

현재 SK하이닉스는 HBM 시장에서 50% 이상의 점유율을 차지하고 있으며, 삼성전자와 마이크론이 그 뒤를 따르고 있어요. 하지만 기술 격차와 엔비디아와의 긴밀한 협력 관계를 고려하면, SK하이닉스의 리더십은 당분간 계속될 것으로 보입니다! 🥇

❓ HBM 관련 자주 묻는 질문 (Q&A)

Q1. HBM과 일반 D램의 가격 차이는 얼마나 되나요?

A. HBM은 일반 D램보다 10배 이상 비싸요. 복잡한 제조 공정과 높은 기술력이 필요하기 때문이죠. 하지만 AI 서버에서는 성능과 전력 효율이 훨씬 중요하기 때문에, 가격이 비싸도 HBM을 선택할 수밖에 없답니다! 💵

Q2. 삼성전자도 HBM을 만드는데 왜 SK하이닉스보다 뒤처졌나요?

A. 삼성전자는 초기에 TC-NCF 방식을 고집하다가 수율 문제를 겪었어요. 최근에는 MUF 방식으로 전환했지만, 이미 SK하이닉스가 엔비디아와 긴밀한 파트너십을 구축한 후였죠. 기술 격차와 함께 고객사와의 신뢰 관계도 중요한 경쟁 요소랍니다! 🏃

Q3. HBM4는 언제 나오나요?

A. HBM4는 2025년 하반기부터 본격적으로 양산될 것으로 예상돼요. 현재 HBM3E보다 대역폭이 50% 이상 향상되고, 적층 수도 더 늘어날 전망이에요. SK하이닉스는 이미 HBM4 개발을 완료하고 고객사 검증을 진행 중이라고 밝혔답니다! ⏰

🎬 이 글을 마무리하며

오늘은 AI 시대의 숨은 주역, HBM 메모리에 대해 자세히 알아봤어요. 😊 단순한 메모리 칩이 아니라 AI 혁명을 이끄는 핵심 기술이자, 새로운 반도체 권력의 원천이라는 사실을 이해하셨을 거예요!

SK하이닉스의 독보적인 기술력과 엔비디아와의 전략적 파트너십이 만들어낸 성공 스토리는 정말 흥미롭지 않나요? 앞으로 AI 기술이 더욱 발전하면서 HBM의 중요성도 계속 커질 것 같아요. 💪

여러분은 HBM 메모리에 대해 어떻게 생각하시나요? SK하이닉스의 성장세가 계속될 것 같으신가요? 댓글로 여러분의 생각을 자유롭게 나눠주세요! 👇

다음에는 더 유익하고 재미있는 IT 기술 이야기로 찾아뵐게요. 오늘도 제 블로그를 방문해주셔서 정말 감사합니다! 자주 놀러 와주세요~ 🙏✨